Фото: ZDnet

Нейросеть ChatGPT стала намного «глупее», нежели раньше. После недавнего обновления языковая модель GPT-4 в некоторых случаях почти никогда не дает правильный ответ на запрос, сообщает The Tech News.

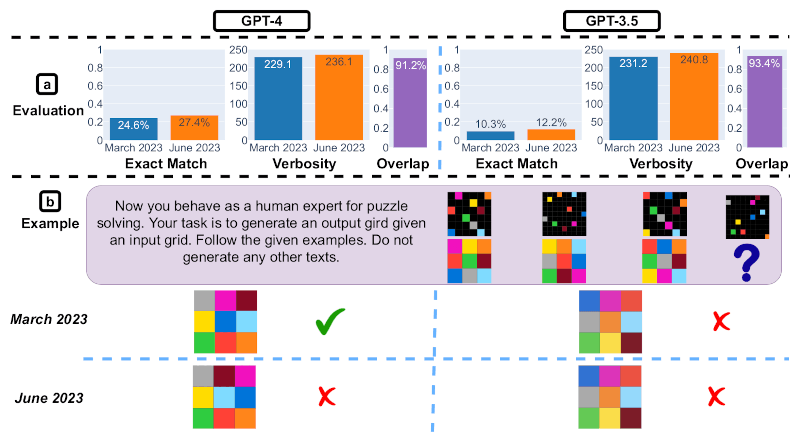

Исследователи Стэнфордского университета провели анализ работы искусственного интеллекта. Нейросеть должна была ответить, является ли число 17 077 простым, расписывая вычисления шаг за шагом.

В марте модель GPT-4 давала правильный ответ в 97,6% случаев, в июне показатель упал до 2,4%. Чат-бот почти никогда не мог правильно ответить на вопрос. В случае GPT-3.5 показатель вырос с 7,4% до 86,8%, — говорится в сообщении.

Фото: technewsspace.com

В последней версии чат-бота также ухудшилась генерация кода. Для анализа был создан набор данных с 50 простыми задачами из LeetCode. Ученые измерили, сколько ответов GPT-4 выполнялись без каких-либо изменений.

Мартовская версия успешно справилась с 52% проблем, но при использовании июньской модели этот показатель упал до 10%, — отметили эксперты.